CONTEXTUALIZAÇÃO E EVOLUÇÃO DAS INTERFACES GRÁFICAS DIGITAIS

A interface Gráfica que hoje é possível observar em sistemas operativos, programas e aplicações passou por um longo processo de evolução como forma de aprimorar a interação e torná-la acessível. Em 1950, a interação com a interface era realizada por especialistas que inseriam cartões perfurados em computadores massivos, aguardando um resultado indicado por luzes caso o sistema correspondesse de forma positiva. O Computador Pessoal (PC) surgiu para introduzir maneiras inéditas de pensar e interagir com essas máquinas. Para que essa interação ocorresse, áreas como o design e a psicologia foram desenvolvidas com o objetivo de inserir esses novos utilizadores ao contexto em que se encontravam, resultando no surgimento de novos estilos de interfaces gráficas digitais. Para demonstrar o desenvolvimento da interface, esta dissertação de mestrado baseou-se na importância da interdisciplinaridade, no surgimento de novas áreas como Experiência do Utilizador (UX) e Interface do Utilizador (UI), e na análise do aparecimento de novos estilos que se desenvolveram devido a uma busca contínua de aprimoramento por parte de grandes empresas como a Microsoft, Apple e Google. Por meio de um estudo de casos e de conceitos históricos e científicos, o presente trabalho visa contribuir literariamente com o intuito de ampliar o interesse sobre o tema abordado e incentivar a criação de novos projetos gráficos e tecnológicos capazes de modificar nossa percepção do mundo, onde a premissa deve ser construída em prol da satisfação do elemento humano.

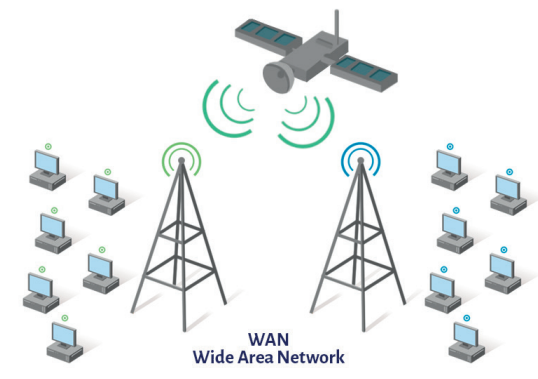

A Terceira Revolução Industrial, também reconhecida como Revolução um Tecnocientífica, teve início em meados do século XX, na época pós-Segunda Guerra Mundial. Engloba o período de maior progresso tecnológico, que não apenas envolveu o sistema produtivo, mas também se voltou para o campo científico, alterando as relações sociais e o cotidiano da sociedade. As tecnologias introduzidas, e que passaram a ficar ao alcance da população, alteraram as formas de comunicação, as informações começaram a ser disseminadas instantaneamente, alcançando pessoas em todo o mundo.

A quebra de limites físicos e essa conexão social, econômica, política e cultural tornaram-se conhecidas como globalização. Dada a necessidade, as Interfaces Gráficas presentes nos sistemas operacionais, programas e aplicações atualmente foram progressivamente aprimoradas ao longo do tempo. Avanços ao longo da história humana decorrem de progressos tecnológicos, melhores abordagens de desenvolvimento e a compreensão de que uma interface gráfica vai além do visual ou do próprio sistema; deve ser centrada no usuário e em suas capacidades. Com isso, o campo do design visual também teve progressos importantes, onde princípios e padrões foram elaborados para aprimorar a experiência de interação como objetivo principal, tornando-a agradável e acessível.

Para melhor entendimento dos avanços da representação visual ao longo do tempo, é essencial analisar o contexto permitindo aprofundar o conhecimento sobre o tema e, por conseguinte, fornecer fundamentos para novas pesquisas.

Para explicar como e por que foi conduzido este estudo histórico sobre as interfaces, tornou-se relevante realizar uma breve exposição das abordagens psicológicas e visuais dos conceitos que englobam o tema. Observando como o ambiente afeta a interpretação de símbolos em suas diversas significações, influenciando, portanto, as percepções humanas e suas interações.

Antes de começar uma investigação mais profunda sobre as esferas da psicologia cognitiva e gestáltica em uma interface gráfica digital, é crucial apresentar a interação entre o ser humano e o computador para que, dessa maneira, nosso cérebro opere e desempenhe suas atividades psicológicas humanas.

A Interação Homem-Computador (IHC) é o campo interdisciplinar destinado a desenvolver técnicas e recursos para as esferas de concepção, elaboração, instalação e manutenção de sistemas computacionais visando aprimorar a adequação entre as características comportamentais humanos e o processamento e representação de dados. Uma disciplina que requer a exploração e aprofundamento de diversas áreas de forma a ser utilizada com menor esforço e máxima eficácia possível.

A investigação desse campo teve início com o psicólogo cognitivo Donald Norman, que explorou o conceito de facilidade de uso. Podem-se identificar três fases ao longo da história da Interação Homem-Computador (IHC):

Primeira onda – concentrada nos aspectos humanos. Análise do utilizador como um conjunto de dispositivos de processamento de informação. Enfoque no indivíduo. Estabelecimento de diretrizes para criação de interfaces, métodos formais e avaliações sistemáticas baseadas em medidas.

Segunda onda – direcionada para aspectos humanos. Ênfase em coletividades. Abordagens qualitativas em vez de quantitativas, prototipagem e design situacional. Compreensão integral do indivíduo em determinado contexto.

Terceira onda – enfoque em elementos culturais e estéticos. Expansão do aspecto cognitivo para o emocional. Consideração dos fatores sociais e pragmáticos na experiência. Tecnologias onipresentes, móveis e de dimensões reduzidas. A tecnologia ultrapassa os limites do ambiente de trabalho e passa a fazer parte da cultura, vida e residência das pessoas.

Para Norman, o sistema ideal “oculta” a tecnologia de modo a permitir que o utilizador não perceba sua existência, visando aumentar a produtividade, a capacidade e a satisfação em sua usabilidade. Para que essa relação entre o computador e o utilizador tenha sucesso, é preciso realizar um estudo detalhado do comportamento e uso dessa interface. O design, busca aprimorar a transmissão de informações e favorecer a usabilidade para otimizar o sistema e melhorar a eficiência dessa interface, assim como a humana. Junto com a Ergonomia, por exemplo, é um dos métodos de avaliação que produzem resultados, já que têm como foco principal o utilizador.

Tal como a ergonomia produz resultados significativos na interação homem computador, a psicologia cognitiva investiga a função psíquica que opera na aquisição do conhecimento e ocorre por meio de alguns procedimentos, como a percepção, a concentração, ligação, memória, raciocínio, discernimento, criatividade, pensamento e linguagem – os processos intelectuais que subjazem ao comportamento humano.

Card, Moran e Newell (1983) propuseram a teoria de uma psicologia aplicada no que tange ao processamento de informação.

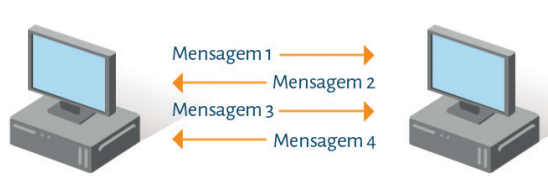

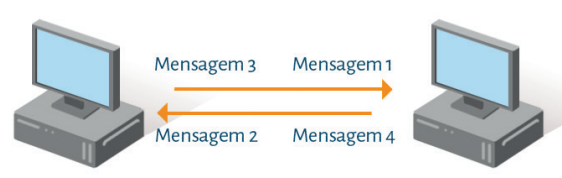

Conforme os autores, a interação homem-máquina consiste na relação e comunicação entre o utilizador e o computador com o propósito de concluir de maneira bem-sucedida a atividade desejada.

Esse diálogo consiste em uma forma fundamental e comum a todos de interface:

o hardware (dispositivos físicos) e os programas informáticos que coordenam a interação, os softwares (componentes virtuais). Para eles, a análise da estrutura da atividade oferece a maior parte do conteúdo antecipatório da psicologia. Uma vez compreendidos os objetivos dos utilizadores e consideradas as suas limitações de perceção e processamento de informação, devemos ser capazes de oferecer respostas a questões que auxiliem na melhoria da atividade desejada.

Com base na psicologia cognitiva em um modelo de processamento de dados, Card, Moran e Newell em seu livro The Psychology of Human-Computer Interaction (1983) desenvolveram o que denominaram de “Modelo de Processador Humano” (MHP). Segundo os autores, a utilização de modelos que enxergam o ser humano como um processador de dados fornece um “esqueleto” comum no qual modelos de memória, de solução de problemas, de percepção e de comportamento podem ser integrados entre si. Ao considerarmos a percepção da mente humana como um sistema de processamento de dados, é viável realizar uma previsão de seu comportamento. O MHP composto por três subsistemas, cada com suas próprias memórias e processadores com alguns princípios de funcionamento: o perceptivo, o motor e o cognitivo.

O processador perceptivo , tal como o próprio nome indica, percebe e comunica as perceções do mundo físico detetadas pelos receptores (visão, audição, tato, olfato, paladar) para representações mentais. Estas são guardadas por tempo limitado em áreas de memória sensorial (sobretudo nas memórias visual e auditiva), ainda codificadas fisicamente e com uma rápida taxa de esquecimento, dependendo da intensidade do estímulo. Posteriormente, algumas são codificadas e armazenadas na memória de trabalho, isto é, um local temporário de armazenamento de informações com capacidade limitada.

O processador cognitivo é a parte deste sistema que escolhe e determina quais conteúdos das memórias sensoriais devem ser codificados e guardados na memória de trabalho, especialmente quando o conteúdo da memória perceptiva for complicado ou percebido apenas por um período de tempo muito breve. O sistema intelectual recebe a informação codificada dos armazenamentos sensoriais na sua memória de trabalho e utiliza dados previamente guardados na memória de longo prazo para tomar decisões sobre como reagir aos estímulos recebidos. O resultado da combinação destas memórias é traduzido em ação através da ativação de padrões de músculos voluntários realizados pelo sistema motor que executa a tarefa desejada.

Os parâmetros a serem considerados quando se trata das memórias são: a capacidade de armazenamento em quantidade de itens, o tempo de esquecimento de um item e o tipo de código principal (físico, acústico, visual ou semântico). Já em relação aos processadores, o critério mais importante é o tempo do ciclo.

Psicologia gestálgica

Max Wertheimer, Wolfgang Köhler e Kurt Koffka (1912) conceberam uma teoria fundamentada em uma investigação de orientação, compreensão e interpretação da nossa visão e da maneira como percebemos os objetos e o universo, denominada Gestalt. Os psicólogos enfatizaram que nosso cérebro identifica padrões ou configurações completas, não apenas elementos individuais. O termo pode ser bem compreendido por meio do conhecido ditado de Max Wertheimer: “A totalidade é superior à soma de suas partes”.

A mente humana utiliza parâmetros visuais. Ao visualizarmos um conjunto de elementos (indivíduos, itens, cenário, fauna ou escritos), a mente percebe a necessidade de agrupar elementos semelhantes para possibilitar uma interpretação mais rápida. Conforme a teoria da Gestalt, inicialmente percebemos o objeto como uma totalidade para depois analisar suas partes de forma separada.

Max Wertheimer, Wolfgang Köhler e Kurt Koffka (1912) elaboraram um conjunto de princípios teóricos e metodológicos que buscavam reestruturar a abordagem da investigação psicológica. Isso contrasta com as pesquisas desenvolvidas no início do século XX, seguindo a metodologia científica convencional, que fragmentava o objeto de estudo em diversos elementos para análise separada, com o intuito de simplificar a complexidade desse objeto. Para isso, os psicólogos formularam os Oito Princípios da Gestalt como forma de ilustrar sua pesquisa:

Princípio 01 – Lei da Pregnância:

O primeiro princípio indica que o objeto observado deve manifestar equilíbrio em sua totalidade, sendo coeso e suficientemente claro para simplificar qualquer complexidade visual em sua estrutura. Nisso, sua implementação consiste em: arranjo (permitindo uma compreensão clara e rápida do objeto) e mapeamento de conduta (refere-se ao comportamento automático gerado pela mente, necessário para moldar e utilizar na criação de formas mais simples para a compreensão).

A primeira análise realizada pelo cérebro diz respeito às formas: um conjunto de 5 blocos empilhados com alturas distintas no centro da imagem e depois as cores específicas dos elementos que se destacam do fundo neutro. Se esses elementos e marcas são reconhecíveis pelo receptor, o logotipo seria apenas usado como parte reafirmadora do anúncio. De qualquer modo, o matiz vermelho intenso do logotipo, guia o olhar do receptor para concluir que o objeto observado são peças de Lego, enquanto a palavra “imagine” é apresentada como sugestão de ação e representação da animação e série de comédia americana criada por Matt Groening: Os Simpsons. Confirmando o propósito de simbolizar os personagens principais da série: Homer, Marge, Bart, Lisa e Maggie.

Ao confrontarmos o anúncio do jornal Gazeta Mercantil (figura 02), podemos notar a abordagem distinta escolhida para a criação da peça visual. Vários componentes devido às tonalidades e seus significados reunidos, são interpretados como um componente de natureza política. No entanto, a conclusão da mensagem só pode ser alcançada após a leitura da expressão “Compreenda o verdadeiro valor do dinheiro”.

A moeda apresentada abaixo é o Yen e a disposição de imagens mostra parte do contexto do Japão. Devido à presença de muitos elementos em conflito e à necessidade de mais tempo para compreender o anúncio, essa peça tem menor destaque, porém é facilmente compreensível. Em outras palavras, uma peça de menor destaque pode alcançar seu objetivo se for usada adequadamente para que o público-alvo capture a mensagem. Para o desfecho para ser eficaz na comunicação, o designer deve considerar a estrutura geral da peça e se a interpretação realmente é coerente ao reunir todos os elementos da composição.

Claro, aqui está o texto com algumas palavras substituídas por sinônimos e equivalentes de verbos:

Princípio 02 – Lei da Unidade:

Como complemento à Lei da Pregnância, temos a unidade. Dentro das leis da Gestalt, a unidade é fundamental para a interpretação da forma. A unidade refere-se à estrutura que pode ser percebida e interpretada como uma entidade única, sendo predominante em relação à imagem e à informação.

Além disso, está distinto do entorno que o rodeia, embora seja formado por várias outras partes. Como segunda lei entre os princípios da Gestalt, a regra da unificação é crucial na produção, pois está presente na organização e disposição de elementos, permitindo criações originais e inovadoras a partir de elementos já existentes. Como exemplo da regra da unificação, podemos observar na figura abaixo o anúncio da Heinz utilizando fatias de tomate para criar a forma de uma garrafa de ketchup.

convencional. O objetivo do anúncio é destacar que a marca valoriza a qualidade e a autenticidade do produto sem aditivos: “Ninguém produz ketchup como a Heinz”.

Princípio 03 – Lei da Unificação:

Dentre as leis da Gestalt , a unificação indica a capacidade de identificarmos unidades pertencentes a um mesmo grupo. Por meio dela, aprendemos a conectar diferentes elementos, mas que possuem estrutura semelhante que os invoquem a um meio. Da mesma forma, exemplificando, é possível observar a presença da Lei da Unificação na arte da campanha da marca Mercedes Benz , onde há duas unificações diferentes percebidas. Cada uma é caracterizada a partir de formas, texturas e cores, onde o lado racional (esquerdo) se dá há um conjunto de unidades mais rígidas e cores pouco saturadas e o lado emocional (direito) do cérebro representado e unificado pela fluidez das tonalidades e configurações. Assim, são formadas duas entidades em um único quadro.

Princípio 04 – Lei da Semelhança:

A lei da semelhança é uma das diretrizes da Gestalt mais simples de serem identificadas. O elemento específico que auxilia na unificação de peças e elementos é a similaridade. Características muito próximas associam objetos e seres como parte de um mesmo conjunto. Por exemplo, mesmo que uma criança não compreenda o que são gatos, ela reconhecerá pelas similaridades que aquele grupo de animais pertence à mesma categoria.

Elementos que possuem formatos, tonalidades ou aspectos visualmente próximos geralmente são percebidos como uma única entidade, como evidenciado pelo anúncio da Shootz Cafe & BillIards.

Onde dois conjuntos de bolas de bilhar com tonalidades parecidas se juntam para criar uma nova disposição.

Princípio 05 – Lei da Proximidade:

A regra da proximidade indica a percepção de elementos próximos como originários de um mesmo conjunto. Com isso, passam a ser visualizados como componentes únicos ou até mesmo partes específicas pertencentes a uma totalidade. Na aplicação das leis da Gestalt, a proximidade é o ponto de partida para a conexão. Quando associada à lei da semelhança, a interpretação visual se torna ainda mais intensa. Por conseguinte, a compreensão da configuração torna-se mais fácil, agradável e rápida, o que é crucial em certas circunstâncias. Segundo a Gestalt, elementos em estreita proximidade, ajustando-se de maneira harmoniosa, são interpretados pelo nosso cérebro como elementos agrupados ou unidades: a regra da proximidade.

sobretudo em fontes e componentes que, teoricamente, seriam usuais, mas com um método simples se convertem em diversos elementos. O desfecho frequentemente se transforma em uma entidade coesa e inovadora, como por exemplo, o emblema em formato de U da Unilever.

O logotipo é uma representação visual do comprometimento da empresa com o cliente. Cada símbolo possui uma significância profunda em seu cerne e simboliza algum aspecto do que a Unilever defende para tornar a vida sustentável e uma área de atuação. Em outras palavras, variados elementos, porém em harmonia entre si devido à sua proximidade.”

Princípio 06 – Regra da Continuidade:

A regra da continuidade refere-se à capacidade do cérebro humano de conceber formas sem interrupção em sua estrutura. Isso facilita uma interpretação mais suave, já que a mente humana antecipa situações envolvendo esse elemento. Trata-se da propensão dos objetos em seguir uma trajetória de fluidez visual gradual. Isso é alcançado por meio de formas, traços, tonalidades, profundidade, planos, etc. Se quem recebe a mensagem percebe elementos em uma composição sem interrupções, essa peça possui uma boa continuidade. O foco da continuidade é sempre proporcionar a melhor forma possível visualmente. O anúncio da FedEx demonstra em sequência o processo de envio e recebimento de um produto através da empresa.”

Princípio 07 – Regra do Encerramento:

O cérebro humano interpreta de forma visual e natural a repetição de unidades, pois facilita a compreensão de uma forma e, portanto, busca um encerramento visual para criar imagens vazadas ou abertas, dependendo do contexto. Quando essa imagem é visualizada e mantém uma continuidade fluída, é comum ocorrer o encerramento da imagem. Isso se deve aos padrões sensoriais e à organização espacial presentes em nossa mente.”

“Princípio 07 – Regra do Encerramento:

O cérebro humano interpreta de forma visual e orgânica a repetição de elementos, pois facilita a compreensão de uma forma e, portanto, busca um encerramento visual para criar imagens vazadas ou abertas, dependendo do contexto. No momento em que essa imagem é percebida e mantém uma continuidade fluída, é comum ocorrer o encerramento da imagem. Isso acontece devido aos padrões sensoriais e à organização espacial presentes em nossa mente.”

A campanha da Coca-Cola elaborada pela agência McCann, que visa mencionar novas técnicas de preparo incorporando a Coca-Cola como um dos ingredientes, ilustra de maneira direta a lei do fechamento. Os ícones de um garfo e uma faca posicionados lado a lado, formam, em negativo, o reconhecível formato da garrafa de refrigerante Coca-Cola. A logomarca aplicada de forma circular torna o fechamento praticamente secundário da campanha.

Princípio 08 – Lei da Separação:

Finalizando os princípios da Gestalt, a separação é outro elemento na interpretação de uma imagem. Este elemento refere-se à habilidade de separar unidades dentro de uma mesma figura. A quantidade de separações viáveis depende diretamente da complexidade e do tempo de observação. O cérebro humano é capaz de distinguir ou destacar objetos, mesmo quando estão sobrepostos. Isso ocorre devido à variação de configuração e estilo que um elemento possui em comparação com outro. Assim, os estímulos visuais de cada unidade também são distintos, já que a separação acontece de várias maneiras, por meio de: pontos, traços, superfícies, dimensões, sombras, brilhos, texturas, relevos, entre outras formas.

Na ilustração anterior , é possível visualizar a estreia da app de entregas do McDonald’s. Sob a supervisão criativa da Tricia & Tina, a empresa tornou os dispositivos móveis atrativos devido à combinação de cores e designs, aparecessem produtos icônicos da marca como, por exemplo, o Big Mac, as batatas fritas e o McMuffin.

Claro, vou substituir algumas palavras por sinônimos ou equivalentes verbais:

Visão de Cores e Luminosidade

Um dos principais componentes de uma interface visual é a cor. A observação de cores e luminosidade (avaliação da densidade e força de uma luz refletida em uma direção específica) está incorporada em um conjunto de componentes que constituem a linguagem visual da interface gráfica, guiando e ajudando o cérebro a identificar os objetos. Através da aplicação da psicologia cognitiva e gestáltica, a interpretação desses elementos busca aprimorar a praticidade do sistema e orientar a navegação pela interface gráfica digital de maneira intuitiva e bem-sucedida.

A literatura indica que as tonalidades são sensações interpretadas pelo nosso cérebro quando nossos olhos são estimulados por uma faixa específica do espectro de ondas eletromagnéticas – a luz (Guimarães, 2000). Segundo Barros (2006), a cor e sua luminosidade sempre foram uma ferramenta utilizada pelo ser humano como canal de comunicação, expressão de conhecimentos e emoções. A tonalidade é percebida como um dos meios de recepção de comunicação mais imediatos, escolhida com base na contextualização da informação e na estrutura dos códigos culturais. Conforme Guimarães (2003), as tonalidades desempenham papéis específicos que podem ser divididos em dois conjuntos:

- Entende as estruturas e as conexões classificatórias, tais como: organizar, atrair atenção, ressaltar, desenvolver esquemas de percepção, estratificar dados, guiar a leitura, etc;

- Entende as relações de significado, como: situar no ambiente, representar simbolicamente, sugerir e explicitar significados.

Ao implementar em uma interface gráfica digital, a interpretação das tonalidades e brilhos pode desempenhar uma função crucial no que diz respeito à praticidade:

- Chamar a atenção: Botões ou áreas relevantes da tela apresentam tonalidades distintas para chamar a atenção e atrair;

- Mostrar estado da ação: À medida que o estado se torna mais crucial, a cor do elemento pode sofrer mudanças;

- Tornar atrativo: Embora o objetivo seja a praticidade, é essencial assegurar que a paleta de cores seja atraente aos olhos;

- Destacar informações: A cor pode ser empregada para estruturar a tela ou evidenciar a perspectiva.

Entre os métodos de aplicação de cores em uma interface, o uso da diferenciação se destaca como o mais efetivo devido à maior sensibilidade do sistema visual humano (Campbell & Maffei, 1974). A diferenciação é definida como a variação de luminância ou cor que torna um objeto (ou sua representação em uma imagem ou tela) discernível. O contraste de tonalidade, ou seja, a diferença entre o claro e o escuro (luminância), é considerado o mais eficaz. Os efeitos cromáticos também são amplificados ou reduzidos pelo contraste de tonalidade das cores. Uma mesma tonalidade pode sofrer variações ao contrastar com outras cores, alterando a sua percepção. Um círculo cinza-claro parece mais sombrio em um fundo branco do que em um fundo preto e parece maior no fundo preto do que no fundo branco. Até mesmo a cor cinza sobre um fundo branco parece ser mais escura do que quando sobre um fundo cinza-médio.

As diferenças, segundo Da Vinci (PEDROSA, 2008), são abordadas pela reciprocidade e reversão, também enfatizando que toda a tonalidade ressalta mais ao lado de sua cor complementar. A diferença entre as cores vibrantes, puras e saturadas se destacam quando o branco e o negro estão presentes nessa composição, ou seja, o contraste claro-escuro explora o valor tonal das cores e o uso da luminosidade (PEDROSA, 2008).

Examinar a Psicologia Cognitiva Aplicada e Gestáltica integradas no surgimento das interfaces, especialmente no que se refere à percepção cerebral acerca das cores e formas, é adotar a relevância da centralização do ser humano no procedimento de criação. Entender como novos tipos de dados são absorvidos pelo cérebro humano com o intuito de diminuir a complexidade dessa ação é possuir uma ferramenta crucial para o aprimoramento de uma interface que atenda às expectativas e cumpra sua função com eficácia, tornando-a mais acessível e melhorando sobretudo a experiência do usuário.

Capítulo 02: Vivência do Utilizador

(UX)

Frederick Winslow Taylor e Henry Ford lideravam a exploração de novos métodos para tornar o labor humano mais eficaz e produtivo. A pesquisa inovadora de Taylor em 1948 sobre a efetividade das interações entre trabalhadores e suas ferramentas é o exemplo mais antigo que se assemelha aos alicerces da vivência do utilizador nos dias atuais. O Taylorismo, sistema de gestão concebido por Frederick Taylor (1856-1915), é caracterizado pela ênfase nas tarefas, visando o aumento da eficácia ao nível operacional, ou seja, eficácia do trabalho, que envolve realizar as tarefas de forma mais inteligente e com a máxima economia de esforço. Para isso, era necessário escolher adequadamente o operário e instruí-lo na função específica que iria desempenhar. Taylor em 1948 já percebia a interação entre o ser humano e a máquina como algo capaz de revolucionar a indústria e posteriormente estimular novas formas de aplicação para seu modelo.

Em 1955, o projetista industrial Henry Dreyfuss redigiu o renomado “Designing for People” no qual enfatizava a ligação entre as pessoas, sua vivência e o design de um produto de sucesso. Dreyfuss (1955) expressou: “Se o ponto de interação entre o produto e as pessoas se transforma em um ponto de atrito, então o projetista falhou. Por outro lado, se as pessoas se sentirem mais seguras, confortáveis, mais inclinadas a adquirir, então o projetista obteve êxito”. As declarações de Dreyfuss podem ser empregadas para ilustrar o campo em expansão do design de vivência do utilizador hoje, juntamente com muitas das concepções e princípios de design sobre os quais ele escreveu.

Até o término da década de 1970, os computadores predominantes eram os Mainframes, conhecidos por suas dimensões, capacidade de armazenamento, capacidade de processamento e elevado nível de confiabilidade. Eles ainda são predominantemente utilizados por grandes instituições para aplicações que demandam grandes volumes de processamento de dados. Devido à sua complexidade, a maioria dos escritórios operava da mesma maneira no início da década de 1970: arquivos metálicos, máquinas de escrever, papel carbono e memorandos eram partes integrantes.

do quotidiano. Contudo, com a chegada do computador pessoal (PC), tudo o que se compreendia de interação e vivência do utilizador seria ajustado a uma nova realidade.

O termo Vivência do Utilizador surgiu pela primeira vez no livro do especialista em design de UX Donald Norman, “The Design of Everyday Things” (1988). D. Norman assinalou uma mudança do termo anterior “design de sistema centrado no utilizador” no qual, em vez de se focar no próprio sistema e na estética da interface, Norman concentrou-se nas necessidades do utilizador. Numa entrevista ao Adaptive Path, Norman disse: “Eu criei o termo porque achei a interface humana e a usabilidade muito restritas. Eu quis abranger todos os aspectos da vivência da pessoa com o sistema, incluindo o design industrial, a interface, a interação física e o manual. Desde então, o termo se difundiu amplamente, ao ponto de começar a perder o significado.”

O design de vivência do utilizador (UX) é o processo de design para criar produtos que proporcionem experiências significativas e relevantes e que se envolvam em todo o processo de aquisição e integração do produto. Para desenvolver uma UX, é preciso considerar questões como o porquê, o quê e como utilizar o produto. O Porquê envolve as motivações dos utilizadores, sejam elas relacionadas a uma tarefa que desejam realizar ou a valores e visões que os utilizadores associam à posse e ao consumo. O Quê trata das interações que podem ser realizadas – sua funcionalidade. Por fim, o Como se refere ao desenho da funcionalidade de maneira acessível e esteticamente agradável.

Para compreender a importância do ser humano no processo de design de uma interface e proporcionar vivências significativas e relevantes aos utilizadores, é necessário analisar previamente aspetos importantes como a ergonomia e a arquitetura de informação.

Ergodesign: A Ergonomia das Interfaces Gráficas

Ergonomia é a investigação científica das relações entre o ser humano e o sistema, visando o incremento, a performance, o conforto e a qualidade de vida da sua utilização. Conforme Cybis (1998), devido ao processo de informatização, o estudo da ergonomia adquire importância perante a sociedade, permitindo que utilizadores leigos consigam realizar tarefas bem-sucedidas antes consideradas improváveis.

No entanto, visando eliminar as disparidades existentes entre as disciplinas de Ergonomia e Design, surgiu o conceito de Ergodesign e pode ser incorporado em outros conceitos como “facilidade de uso”, “design orientado ao utilizador”, “vivência do utilizador”, onde o enfoque está no utilizador e na sua relação com qualquer interface. A ergonomia num projeto de interface gráfica estabelece a ligação entre o ser humano e a ação executada, procurando criar uma integração perfeita entre as condições apresentadas, considerando as capacidades e limitações do utilizador e a eficiência da ação.

Esta análise mais aprofundada da relação entre utilizador e sistema pode ser dividida em dois principais eixos. No que diz respeito à utilidade do sistema, aborda os recursos funcionais e de desempenho necessários para a execução das tarefas para as quais foi concebido; e no que tange à facilidade de uso, está relacionada à qualidade do sistema em facilitar a manipulação e o aprendizado (ABRAHÃO, 2005). O desenho ergonómico da interface leva em conta funcionalidades práticas, aspetos estéticos e de facilidade de uso. A base nesses três fatores proporciona à interface a capacidade de atender às necessidades dos utilizadores, apresentando e fomentando um fluxo contínuo entre a interação de hardware e software.

Arquitetura de informação

Claro, aqui está o texto com os verbos substituídos por equivalentes e algumas palavras trocadas por sinônimos:

O Information Architecture Institute (Instituto de Arquitetura da Informação) tem como descrição: “A organização da informação é a prática de decidir como estruturar as partes de algo para torná-lo compreensível.”. Assim como a ergonomia, organiza a interação, a arquitetura de informação estrutura de maneira prática as informações. É a configuração e hierarquização de dados de um sistema com o objetivo de facilitar a utilização para determinados utilizadores. Conforme Rosenfield e Morville (2002), a arquitetura de informação é composta por um conjunto base de elementos que atuam de forma integrada:

- Navegação: Especifica os modos de deslocamento, de movimentação pelo espaço informacional e hipertextual;

- Organização: Determina a agrupação e categorização do conteúdo informacional;

- Rotulação: Auxiliam no reconhecimento de controles e influenciam a sequência das atividades. Estabelecem formas de representação e apresentação da informação, definindo símbolos para cada elemento informativo;

- Busca: Determina as perguntas que o utilizador pode fazer e o conjunto de respostas que irá obter. A busca é um serviço secundário de navegação;

- Tesauros, vocabulário controlado e metadados: Auxiliam na navegação suplementar oferecendo recursos que permitem cruzar conteúdos por relações diretas ou dependência.

O pesquisador James Garrett, no livro “The Elements of User Experience”, desenvolveu um diagrama visual separado no qual o autor chama de “camadas para apresentar o processo de evolução das atividades de UX”. Conforme o diagrama proposto por Garrett, todos os produtos digitais partem de um conceito/ideia, e a partir dessa definição se moldam até atingir o produto final.

O planeamento e a definição da Arquitetura da Informação estão diretamente relacionados a grande parte das atividades do fluxo de UX, pois as definições de como as informações devem ser estruturadas e exibidas para os utilizadores ocorrem antes mesmo do desenho do “esqueleto” da aplicação. Isso ocorre porque são aspetos abstratos que antecedem a aparência da interface. Para James Garrett, o alicerce do processo é a definição de uma estratégia, que busca compreender o que o utilizador espera de um determinado produto (que neste caso pode ser um website ou um app, sistema operacional, etc). A partir dos dados iniciais recolhidos, a próxima etapa de desenvolvimento é a elaboração do escopo, ou seja, qual objetivo se pretende atingir com determinado produto. Para isso é feito um levantamento detalhado de requisitos e especificações das funcionalidades, bem como atributos que irão medir a qualidade e como o projeto deverá ser conduzido. Em seguida, o próximo passo é definir a estrutura do produto e determinar como o conteúdo será organizado: o que é mais e menos importante para os utilizadores e como deve ser.

definidas as normas relacionadas à facilidade de uso do que será desenvolvido. A partir do desfecho das definições apresentadas acima, é viável elaborar o esqueleto do produto, o desenho e a organização dos elementos e componentes que constituirão a aplicação. Por fim, como desdobramento do processo, é possível visualizar a superfície, que representa a interface gráfica digital obtida como resultado final.

Design Centrado no Utilizador (DCU)

O Design Centrado no Utilizador (DCU) é um processo de design no qual a criação se focaliza nos utilizadores e em suas necessidades ao longo de todo o processo de desenvolvimento. É uma abordagem inovadora para resolver problemas: começa com as pessoas e culmina em soluções individuais adaptadas às suas necessidades.

No DCU, são empregados uma variedade de métodos e ferramentas de investigação (por exemplo, pesquisas e entrevistas) e métodos geradores (por exemplo, tempestade de ideias) para conceber e visualizar um entendimento mais amplo das necessidades, visando satisfazê-las de maneira mais eficaz. O DCU valoriza todas as fases da experiência do utilizador, portanto envolve profissionais de áreas diversas (por exemplo, etnógrafos, psicólogos, engenheiros de software e hardware), assim como especialistas em domínio, partes interessadas e os próprios utilizadores.

Nos últimos anos, muitas empresas adotaram o design voltado ao utilizador (UCD) em sua estratégia organizacional. IKEA, Lego, Google, Facebook, Microsoft e Apple, em vez de focarem na tecnologia, direcionaram sua atenção para a conexão emocional atrativa entre seus produtos e o consumidor. Os princípios de design centrado no utilizador incluem os seguintes fatores responsivos:

- Uma compreensão clara dos utilizadores, tarefas e ambientes;

- Design direcionado para avaliação;

- Consideração da experiência global do cliente;

Segundo Susan Weinschenk, Ph.D (América Human Factors International), três dos doze principais motivos pelos quais os projetos de TI falham estão diretamente ligados à experiência do utilizador ou ao trabalho de design centrado no utilizador: requisitos pouco definidos, problemas na comunicação entre clientes, desenvolvedores e utilizadores, e conflitos de políticas das partes interessadas. Outros motivos incluem objetivos do projeto irrealistas, avaliação incorreta dos recursos necessários, má representação do status do projeto, entre outros. Através de entrevistas com as partes interessadas, pesquisas e testes com utilizadores, o design centrado influencia o sucesso final do lançamento do produto.

Com uma ampla gama de fatores a serem considerados e trabalhados no desenvolvimento de um projeto, estão surgindo ferramentas que ajudam os designers a adotar uma metodologia mais completa ao longo do avanço do campo de Experiência do Utilizador, que continua em expansão. O Honeycomb, por exemplo, é um diagrama que descreve e orienta a compreensão dos sete aspectos essenciais da experiência do utilizador para desenvolvedores e clientes.

Honeycomb: As Facetas da Experiência do Usuário.

Em 2004 Peter Morville concebeu o diagramaw que nomeou como “User Experience Honeycomb” com o propósito de ilustrar aos seus clientes a necessidade de conceber uma experiência do utilizador para além da sua facilidade de uso. Apesar de ser amplamente empregado no processo de criação de um projeto ou avaliação de um sistema interativo, o diagrama ainda não recebeu consenso da comunidade científica ou de qualquer órgão de normalização. Contudo, para esta dissertação, que busca um entendimento geral sobre o UX, dado a importância do utilizador, o diagrama da Honeycomb serve como uma forma de análise do tema. Segue abaixo, juntamente com o diagrama (figura 14), a explicação de cada faceta ou qualidade da experiência do utilizador delineada por Peter Morville.

Claro, aqui está o texto com os verbos substituídos por equivalentes e algumas palavras trocadas por sinônimos:

- Funcional: O produto ou sistema deve ser desenvolvido com o propósito de satisfazer as necessidades do utilizador;

- Usável: Pode-se associar usável com a facilidade de uso. Os produtos ou serviços oferecidos pelas empresas devem estar prontos para serem utilizados;

- Localizável: A estrutura e organização da informação são essenciais para evitar problemas na comunicação entre a interface e o utilizador;

- Confiança: Conclusão bem-sucedida de uma tarefa ou objetivo;

- Atraente: Grau de aceitação do seu produto ou serviço no mercado-alvo.

- Acessível: Uma boa experiência independentemente da capacidade cognitiva de quem está a utilizar o produto ou serviço;

- Valorizado: Tem uma experiência agradável e útil, fidelizando o utilizador.

Neste capítulo foram mencionados tópicos relevantes que colocam o utilizador como centro na criação de uma interface gráfica de maneira estruturada. A experiência do utilizador é válida ao longo de todo o processo de criação, desde o surgimento de uma ideia até ao desenvolvimento do produto final. Um tema abrangente que está em crescimento e tem como principal objetivo facilitar a forma como o utilizador interage com um produto ou serviço, analisando como melhorar cada etapa do processo considerando a facilidade de uso, confiança, acessibilidade, empatia, a tecnologia, entre outros. Mas como o próprio nome sugere, é um estudo da experiência. E para a experiência ser completamente atendida, uma nova área em design deve ser explorada, aplicada e desenvolvida em cada projeto: a Interface do Utilizador.